Nutanix CEを作成する必要があったので覚書。ただし、ESX上に建てた。どうせKVMだから動くだろう。。。

Nutanix CE 2019.11.22 Single Nodeクラスタの作成 (ESX上にネスト環境で構築)

作成に利用した環境

利用したマシン: NUC7i5BNH (Intel(R) Core(TM) i5-7260U CPU @ 2.20GHz)

ESXの環境: vSphere 6.7 U3 vCenterとESX

物理サーバのスペック

CPU

Hyper-threadingでもいいので4CPU以上が必要(4CPUの内訳 2CPU/CVM、1CPUのゲストOSx2)

推奨は8CPU Core以上

メモリ

Nutanic CEの仮想マシンを構築時に16GBし、インストールが完了したら32GBにした。 (インストールするだけなら24GBでも大丈夫そう)

ベース16GB RAM、CVM 2cpu 12GB RAM消費する。

最低でも28GB必要なので、Nutanix CE仮想マシン32GB RAM、ESXホストはメモリ36GB以上必要。

Nutanix CE仮想マシンを32GBで組むと余裕がないので1VMくらいしか稼働できない。

出来る限り32GB以上のメモリをNutanicCEに割り当てる。

ディスク

800GB程度必要だが、Thinで作ればそこまで容量を消費しないがDataStore自体の空きは800GB以上必要

ネットワークカード

物理NICは1つあれば問題ない。

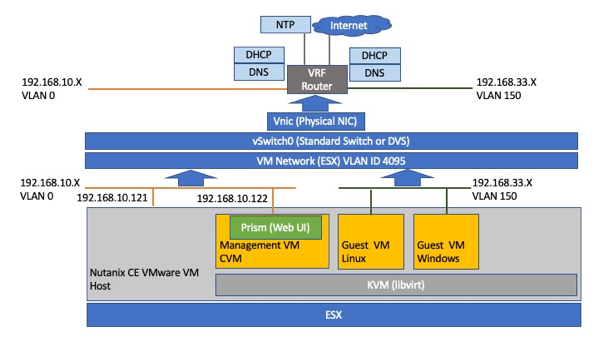

ネットワーク

用意するにはきっちりとしたLAB環境が必要!

以下の太字のネットワークリソースを用意する。

Nutanix CE仮想マシンが接続されるネットワーク

VM Network 192.168.10.0/255.255.255.0 VLAN ID 0

NTP/DNS/インターネット接続が必要

NTP: 192.168.8.1

DNS: 192.168.10.1

GW: 192.168.10.1/24

以下のIP addressを確保する必要がある。(4IP)

Nutanix CE仮想マシン: 192.168.10.121

CVM: 192.168.10.122

Cluster Virtual IP Address: 192.168.10.123

ISCSI Data Services IP: 192.168.10.124

Nutanixでデプロイされる仮想マシンが接続されるネットワーク

Nutanix上でVLANを1つ設置する必要(ESX上にはポートグループなどは作成しない。ESXでは対応する必要は一切なし)

物理機器設定

以下の対応が必要

VRFルータなどVLANパケットをルーティングできるように物理ネットワーク機器を構成

DNS/DHCP

–>vyattaやEdgeRouterでの構築が便利

Test 192.168.33.0/255.255.255.0 VLAN ID 150 DNS/DHCPを設置済み

Guest VM1: 192.168.33.X

Guest VM2: 192.168.33.Y

Guest VM3: 192.168.33.Z

ESX上でのネットワーク設定

Nest環境のESXやHyper-Vが動作する設定にしておく

vSwitchのセキュリティ設定は無差別モードしておくこと。

VM NetworkのVLAN ID 4095

インストール、構築に理解しやすくするためのネットワーク図

必要なメディア

Nutanixのコミュニティのクレデンシャル

Nutanix CEインストール時にコミュニティのクレデンシャルが必要なので、バイナリを別途他から入手したとしてもコミュニティにアカウントを作成しておく必要がある。

以下の3つのファイルはNutanixのコミュニティサイトからダウンロード

Nutanix CE仮想マシンのイメージ

ce-2019.11.22-stable.img.gz

virt-ioのISO (Windows)

Nutanix-VirtIO-1.1.5.iso (OSインストール時に必要)

Nutanix-VirtIO-1.1.5-64bit.msi (OSインストール後に必要)

OSのインストールメディア

全てインターネットあるいは評価版サイトから入手(64bit版)

CentOS7

WIndows Server 2016

など

全体の流れ

1. vmdkファイルの作成

2. Nest Nutanix CE 仮想マシンの作成

3. 仮想マシンの電源オン

4. Nested ESXiへCEをインストール

5. Nutanix CEの設定

6.ゲストの仮想マシンを作成する

7.Nutanix CE仮想マシンのシャットダウンと起動

1. vmdkファイルの作成

ce-2019.11.22-stable.img.gzを解凍する。

ce.vmdkとして以下のファイルを作成 ce-2019.11.22-stable.imgと同じ場所(データストア)におく

—-

# Disk DescriptorFile

version=1

encoding=”UTF-8″

CID=fffffffe

parentCID=ffffffff

createType=”vmfs”

# Extent description

RW 14540800 VMFS “ce-2019.11.22-stable.img”

# The Disk Data Base

#DDB

ddb.adapterType = “lsilogic”

ddb.geometry.cylinders = “905”

ddb.geometry.heads = “255”

ddb.geometry.sectors = “63”

ddb.virtualHWVersion = ”14″

—

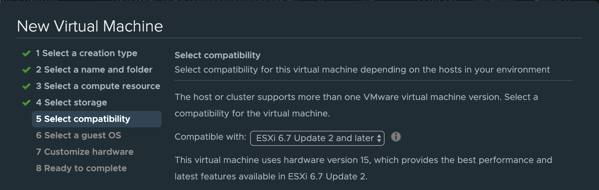

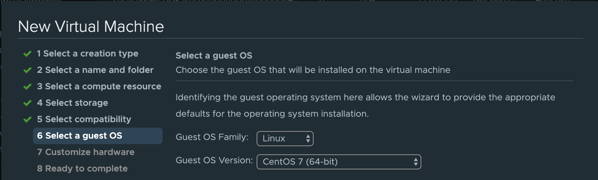

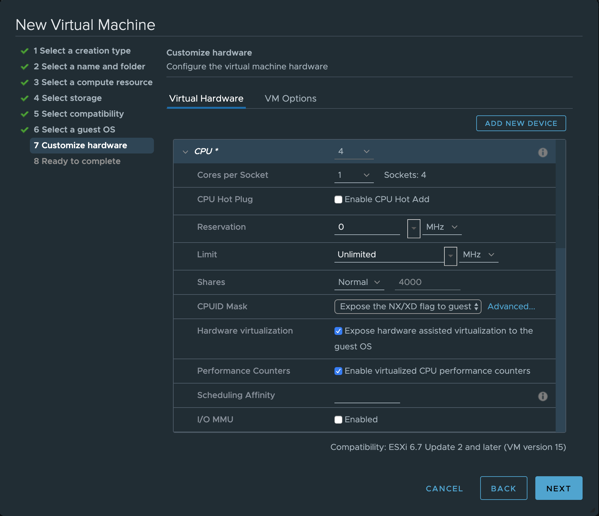

2. Nest Nutanix CE 仮想マシンの作成

vSphere 6.7 U2でCent OS7の仮想マシンを作成

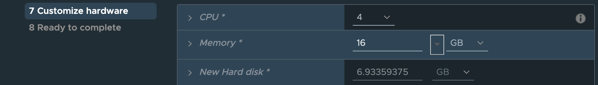

CPU 4以上

ハードウェア アシストによる仮想化をゲスト OS に公開

Hardware virtualizationとPerformance Countersのチェックをオン

Memory

16GB

メモリはセットアップ時は16GBにして、あとで変更したほうがいいらしい。

Hard Disk

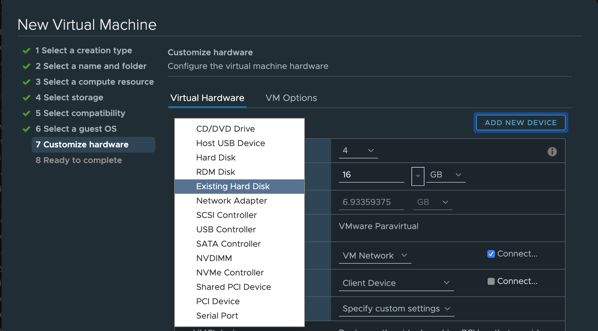

標準で付いてくるディスクを一旦全部削除して、HDDがついてない状態にする

SCSIコントローラに以下のディスクを追加 (合計3本)

ー>前のバージョンだとSATAと書いてあるがParaVirtual SCSIで構わない。というかSCSIの方が性能が良い。

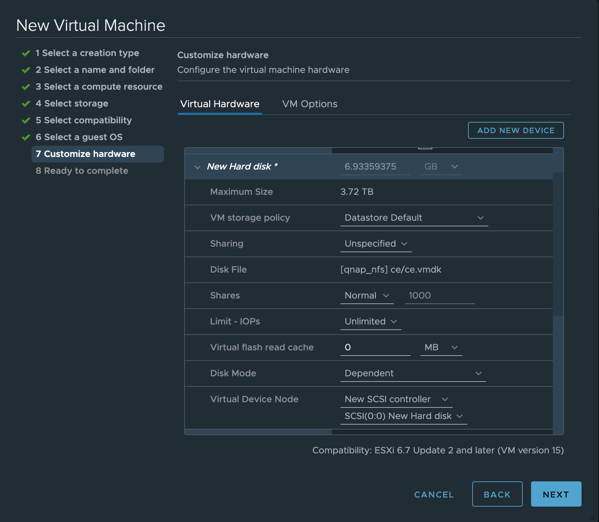

1本目:CE.vmdk (CE.img/CE.vmdk) 既存のディスクととして追加する。

HDD0 7G New SCSI controller SCSI(0:0)

テンプレート化するのであれば、この時点で一旦構築を終わらせる。

このテンプレートから仮想マシンを作成する

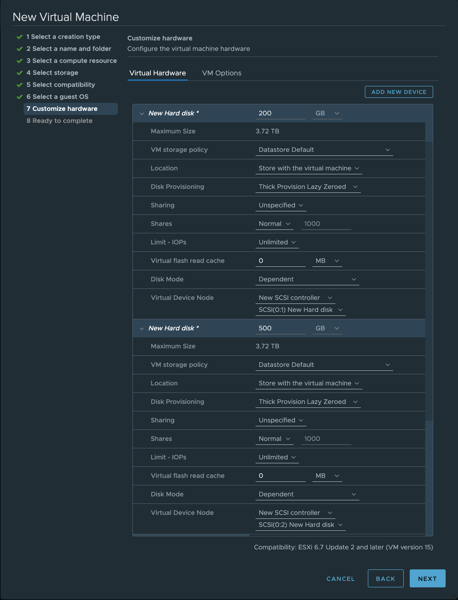

さらにハードディスクをSCSIに追加する。

HDD1 200G New SCSI controller SCSI(0:1)

HDD2 500G New SCSI controller SCSI(0:2)

まとめると

HDD0 7G New SCSI controller SCSI(0:0)

HDD1 200G New SCSI controller SCSI(0:1)

HDD2 500G New SCSI controller SCSI(0:2)

となるはず。

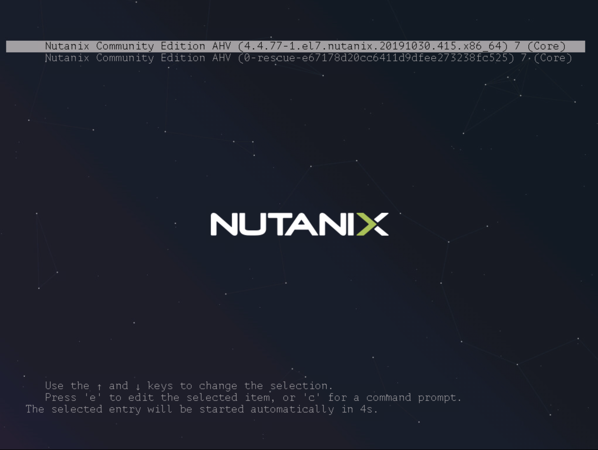

3. 仮想マシンの電源オン

Nutanix CE をインストールする ESX上のVM を起動

きたー

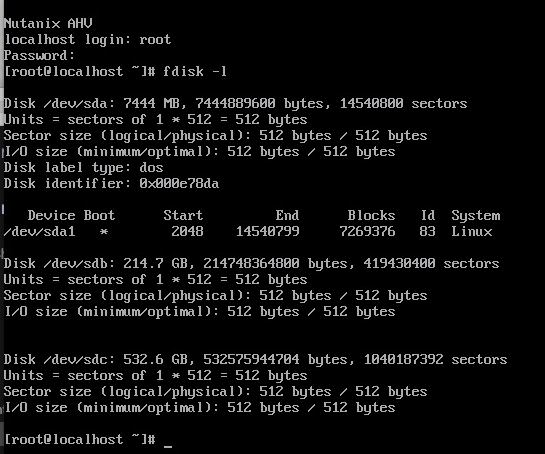

起動をしたら、コンソールから

ユーザ 名: root

パスワード nutanix/4u

でログイン

fdisk -l | grep sd でディスクを確認

* sda(/dev/sda)→ 約 7GB

* sdb(/dev/sdb)→ 約200GB

* sdc(/dev/sdc)→ 約500GB

/dev/sdb を SSD として認識するように下記のように設定

[root@localhost ~]# echo 0 > /sys/block/sdb/queue/rotational

[root@localhost ~]# cat /sys/block/sdb/queue/rotational

0

CVMが起動するように下記のファイルを vi などで編集

vi /home/install/phx_iso/phoenix/svm_template/kvm/default.xml

編集個所

1か所目 (8行目)

machine=’pc’

↓

machine=’pc-i440fx-rhel7.2.0‘

2か所目(これは追記 ESC-15g)

これは「仮想 CPU のパフォーマンス カウンタの有効化」のチェックを ON にできない(EVC を有効にしている)場合に必要

<features>

<acpi/>

<apic eoi=’on’/>

<pae/>

</features>

↓

<features>

<acpi/>

<apic eoi=’on’/>

<pae/>

<pmu state=’off’/>

</features>

root ユーザからのログアウト

ファイルを編集したら、いったん root ユーザからログアウト

[root@localhost ~]# exit

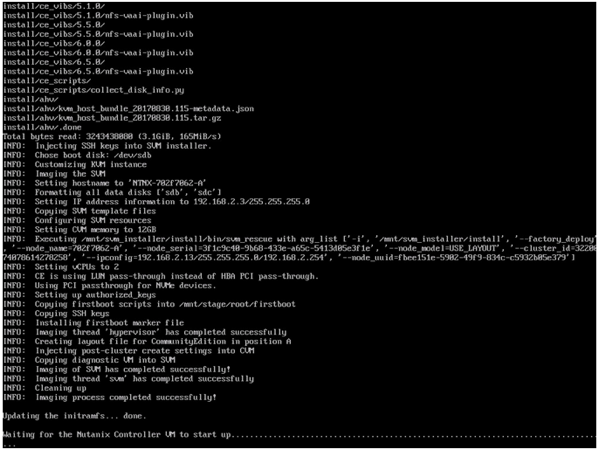

4. Nested ESXiへCEをインストール

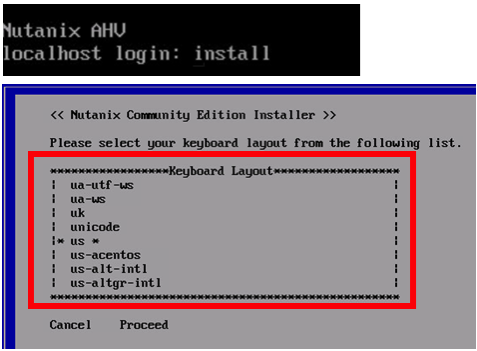

コンソールからinstallユーザ でログイン(パスワードなし)しなおします。

ログインをするとNutanix CEのインストールウィザードが始まります。

キーボードを設定します。

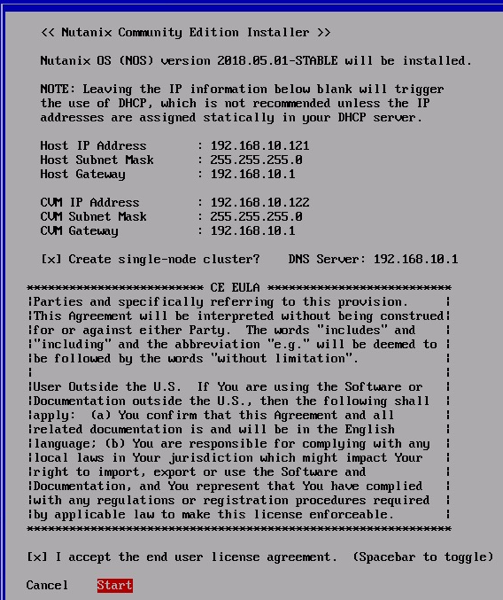

必要なパラメーターを記入

シングルノードで構成したい場合は [×]Create Single-Node Clusterとする。(失敗する場合は、チェックを外してあとでクラスタを作る)

DNSが必要となりますが、実際はNTPサーバとの同期も必要

また、EULAを読まないと次へ進んでももとに戻されて進めないので、必ず最後までカーソルを進めてからStartを選択

Startを実施したら、完了まで10分から20分かかる

インストール成功すれば、以下SSHで作業が可能となる。

sshでHostにroot nutanix/4uでログイン

ssh -l root 192.168.10.121

Nutanix CE仮想マシンにVMware Toolsをインストール

yum -y install open-vm-tools

systemctl enable vmtoolsd

systemctl start vmtoolsd

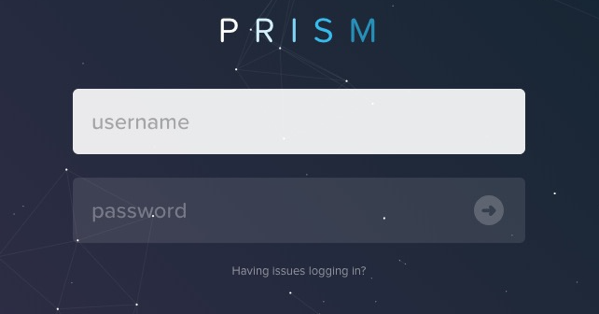

CVMのIPをブラウザで開く

https://192.168.10.122:9440/console/#login

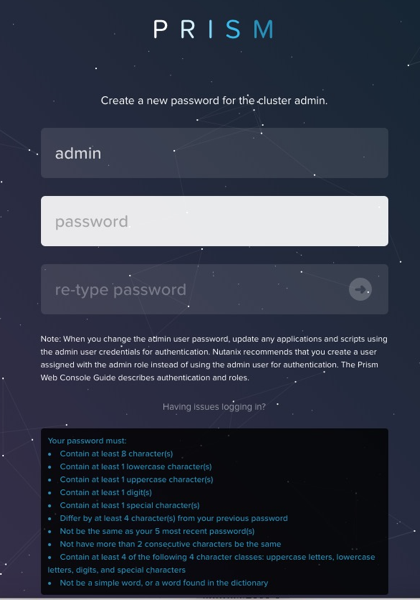

Prismへログインする前のパスワード設定

https://192.168.10.122:9440/console/#login

Prismへログインするにはデフォルトのパスワードを変更

デフォルトユーザー名:admin

デフォルトパスワード:Nutanix/4u

ログインパスワードを設定

admin/ログインパスワード でPrismにログイン(ログインできない場合は、ブラウザをリロードする。)

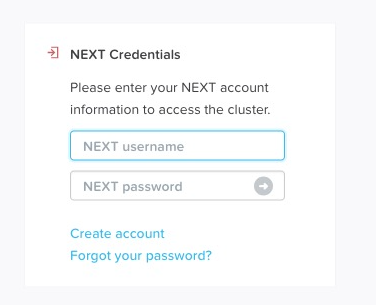

変更後にPrism画面へ入るにはCommunityに登録したメールアドレス、パスワードが必要

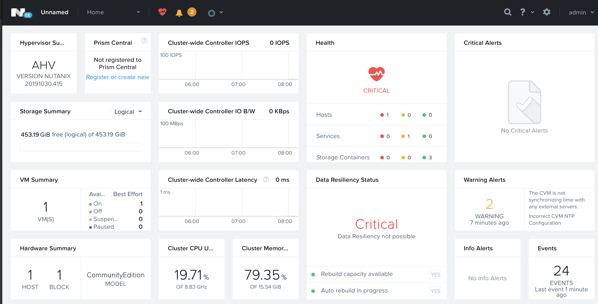

ログインができるとこんな感じになる

Hostにroot nutanix/4uでログイン (ssh-copy-idをしているのはパスワードを入れるのがかったるいから。。。)

ssh-copy-id -i .ssh/id_rsa.pub root@192.168.10.121

ssh root@192.168.10.121

ssh-keygen -t rsa

CVMのVMの設定を変更する

sed -i “s/alias=’pc’//g” /var/cache/libvirt/qemu/capabilities/*.xml

sed -i “s/’pc-i440fx-rhel7.2.0’/’pc-i440fx-rhel7.2.0′ alias=’pc’/g” /var/cache/libvirt/qemu/capabilities/*.xml

diff /var/cache/libvirt/qemu/capabilities/*.xml temp.xml

217c217

< <machine name=’pc-i440fx-rhel7.3.0′ hotplugCpus=’yes’ maxCpus=’240’/>

—

> <machine name=’pc-i440fx-rhel7.3.0′ alias=’pc’ hotplugCpus=’yes’ maxCpus=’240’/>

223c223

< <machine name=’pc-i440fx-rhel7.2.0′ alias=’pc’ hotplugCpus=’yes’ maxCpus=’240’/>

—

> <machine name=’pc-i440fx-rhel7.2.0′ hotplugCpus=’yes’ maxCpus=’240’/>

CVMへSSHでログイン (nutanix nutanix/4u)

ssh-copy-id -i .ssh/id_rsa.pub nutanix@192.168.10.122

ssh -l nutanix 192.168.10.122

cluster stop

sudo shutdown -h now

ー>CVMがシャットダウン

shutdown -h now

ー>Nutanix CE仮想マシンがシャットダウン

メモリのサイズを16GB->24GB以上にあげる

Nutanix CE仮想マシンを起動

起動をしたらrootでログイン

ssh -l root 192.168.10.121

CVMが起動するまで数分まつ

virsh list

setlocale: No such file or directory

Id Name State

—————————————————-

1 NTNX-d51c53d9-A-CVM running

CVMにnutanixユーザ でログイン

ssh -l nutanix 192.168.10.122

cluster status

2020-04-18 11:26:19 INFO zookeeper_session.py:143 cluster is attempting to connect to Zookeeper

2020-04-18 11:26:19 INFO cluster:2784 Executing action status on SVMs 192.168.10.122

The state of the cluster: stop

Lockdown mode: Disabled

CVM: 192.168.10.122 Up, ZeusLeader

Zeus UP [4172, 4205, 4206, 4207, 4218, 4234]

SSLTerminator DOWN []

SecureFileSync DOWN []

Medusa DOWN []

DynamicRingChanger DOWN []

Pithos DOWN []

Mantle DOWN []

Stargate DOWN []

InsightsDB DOWN []

InsightsDataTransfer DOWN []

Ergon DOWN []

Cerebro DOWN []

Chronos DOWN []

Curator DOWN []

Athena DOWN []

Prism DOWN []

CIM DOWN []

AlertManager DOWN []

Arithmos DOWN []

Catalog DOWN []

Acropolis DOWN []

Uhura DOWN []

Snmp DOWN []

SysStatCollector DOWN []

NutanixGuestTools DOWN []

MinervaCVM DOWN []

ClusterConfig DOWN []

Mercury DOWN []

APLOSEngine DOWN []

APLOS DOWN []

Lazan DOWN []

Delphi DOWN []

Flow DOWN []

Anduril DOWN []

XTrim DOWN []

ClusterHealth DOWN []

2020-04-18 11:26:20 INFO cluster:2935 Success!

クラスタが起動していないので、クラスタを開始させる

cluster start

The state of the cluster: start

Lockdown mode: Disabled

CVM: 192.168.10.122 Up, ZeusLeader

Zeus UP [4172, 4205, 4206, 4207, 4218, 4234]

Scavenger UP [5490, 5532, 5533, 5534]

SSLTerminator UP [17496, 17614, 17615, 17619]

SecureFileSync UP [17503, 17605, 17606, 17611]

Medusa UP [18440, 18543, 18544, 18755, 21034]

DynamicRingChanger UP [22652, 22739, 22740, 22890]

Pithos UP [22657, 22684, 22685, 22793]

Mantle UP [22686, 22762, 22763, 22839]

Stargate UP [23645, 23683, 23684, 23854, 23855]

InsightsDB UP [24727, 24813, 24814, 24983]

InsightsDataTransfer UP [24744, 24839, 24840, 24940, 24941, 24942, 24943]

Ergon UP [24755, 24861, 24862, 24864]

Cerebro UP [24768, 24908, 24909, 25121]

Chronos UP [24784, 24954, 24955, 25042]

Curator UP [24803, 24929, 24930, 25124]

Athena UP [24893, 25077, 25078, 25080]

Prism UP [25202, 25316, 25317, 25406, 25416, 25422, 25495, 25496, 25498, 26320, 26388]

CIM UP [25215, 25337, 25338, 25364]

AlertManager UP [25255, 25612, 25613, 25695]

Arithmos UP [25304, 25440, 25441, 25606]

Catalog UP [25335, 25688, 25689, 25690]

Acropolis UP [25373, 25529, 25530, 25534]

Uhura UP [25431, 25596, 25597, 25601]

Snmp UP [25476, 25638, 25639, 25641]

SysStatCollector UP [25516, 25680, 25681, 25685, 27974]

NutanixGuestTools UP [25716, 25772, 25773, 25804]

MinervaCVM UP [26736, 26883, 26884, 26889]

ClusterConfig UP [26759, 26929, 26930, 26931]

Mercury UP [27014, 27088, 27089, 27132]

APLOSEngine UP [27031, 27150, 27151, 27154]

APLOS UP [27803, 27893, 27894, 27898]

Lazan UP [27826, 27940, 27941, 27944]

Delphi UP [27851, 27969, 27970, 27972]

Flow UP [27887, 27996, 27997, 28000]

Anduril UP [27922]

XTrim UP [27967]

ClusterHealth UP [28002]

2020-04-18 11:28:23 INFO cluster:2935 Success!

クラスタが起動したらPRISMにログイン

https://192.168.10.122:9440/console/#login

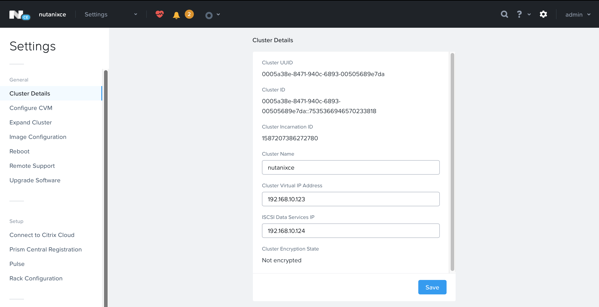

PRISMにログインしたら、初期設定

ClusterのVirtual IPの設定

Cluster Virtual IP Address 192.168.10.123

ISCSI Data Services IP 192.168.10.124

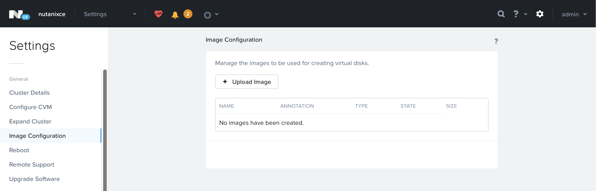

OSのインストールISOとNutanix-VirtIO-1.1.5.isoをアップロード

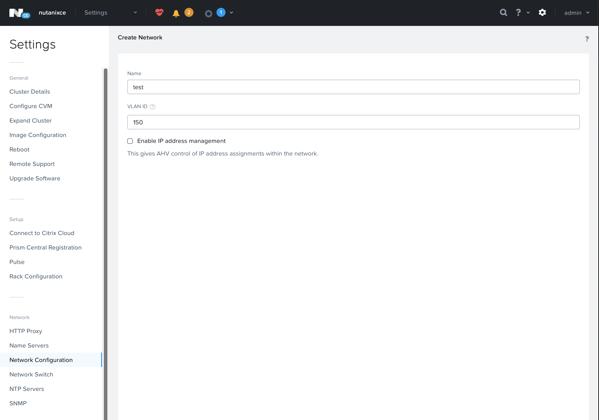

ネットワークの作成

ルーティングされたVLAN IDを指定してネットワークを作成

今回は名前test、VLAN ID 150で作成

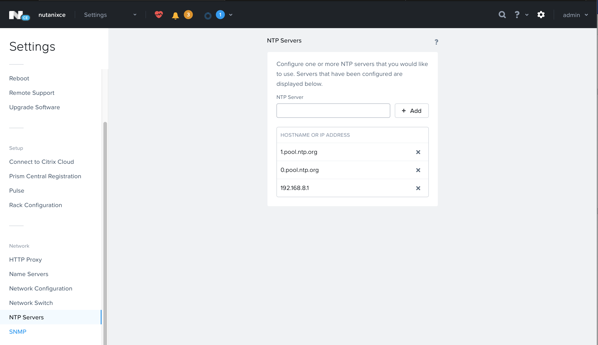

NTPを設定

ゲストの仮想マシンを正常に立ち上げるための設定 (どこにも記載がないw)

CVMのテンプレートを変えたが、ゲストOS用のテンプレートも変更する必要がある。

ssh -l root 192.168.10.121

cp -I /var/cache/libvirt/qemu/capabilities/f4be1fa2d4f264472f03de9360e9ecffe23e924975261d8c90ebae8aeba3f727.xml temp2.xml

sed -i “s/alias=’pc’//g” /var/cache/libvirt/qemu/capabilities/f4be1fa2d4f264472f03de9360e9ecffe23e924975261d8c90ebae8aeba3f727.xml

sed -i “s/’pc-i440fx-rhel7.2.0’/’pc-i440fx-rhel7.2.0′ alias=’pc’/g” /var/cache/libvirt/qemu/capabilities/f4be1fa2d4f264472f03de9360e9ecffe23e924975261d8c90ebae8aeba3f727.xml

diff temp2.xml /var/cache/libvirt/qemu/capabilities/f4be1fa2d4f264472f03de9360e9ecffe23e924975261d8c90ebae8aeba3f727.xml

217c217

< <machine name=’pc-i440fx-rhel7.3.0′ alias=’pc’ hotplugCpus=’yes’ maxCpus=’240’/>

—

> <machine name=’pc-i440fx-rhel7.3.0′ hotplugCpus=’yes’ maxCpus=’240’/>

223c223

< <machine name=’pc-i440fx-rhel7.2.0′ hotplugCpus=’yes’ maxCpus=’240’/>

—

> <machine name=’pc-i440fx-rhel7.2.0′ alias=’pc’ hotplugCpus=’yes’ maxCpus=’240’/>

Nutanix CE仮想マシンの再起動を念のため行う。

ssh -l nutanix 192.168.10.122

cluster stop

sudo shutdown -ht0 now

shurtdown -ht0 now

電源オン

virsh list

ssh -l nutanix 192.168.10.122

cluster start

6.ゲストの仮想マシンを作成する

OS作成 KVMの作成手法に準ずる

http://infraapp.blogspot.com/2017/05/windows-server-200831bitahv1.html

CentOSのインストールの場合

yum -y install deltarpm

yum update -y ; reboot

yum -y install qemu-guest-agent

cat << EOF >> /etc/environment

LANG=en_US.utf-8

LC_ALL=en_US.utf-8

EOF

export LANG=en_US.utf-8

export LC_ALL=en_US.utf-8

# piix4_smbus 0000:00:07.3 Host SMBus controller not enabledを表示させない

cat << EOF >> /etc/modprobe.d/blacklist.conf

blacklist i2c_piix4

EOF

yum -y install mlocate

systemctl enable tuned

systemctl start tuned

tuned-adm profile virtual-guest

systemctl disable firewalld

systemctl stop firewalld

sed -i”.orig” -e “s/SELINUX=enforcing/SELINUX=permissive/g” /etc/selinux/config

setenforce 0

yum clean all

reboot

PrismからManage Guest Toolsもインストール

mount /dev/sr0 /mnt

cd /mnt/installer/linux/

./install_ngt.py

インストールが終わったら

reboot

再度ログインをして

ps aux | grep ngt

でプロセス確認

umount /mnt

Windowsの場合

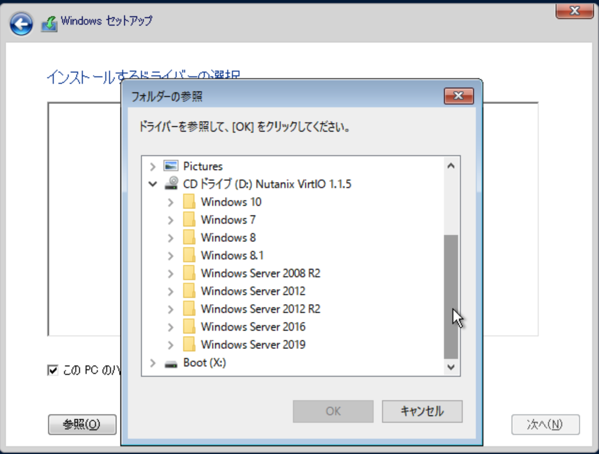

WInのインストーラー起動時、ディスクが見えないのでvirt-ioのISOをマウントしてドライバを指定

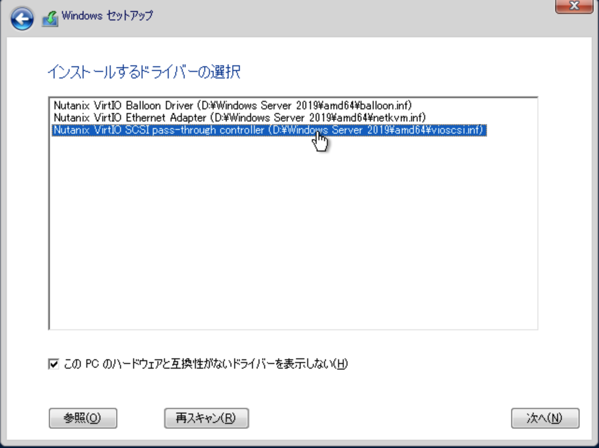

SCSI->Ether->Balloonの順番で3回ドライバーをインストール

ドライバーのインストール後、ISOのマウントをWindowsメディアに戻して、最新の情報に更新をクリックした後にインストール

OSのインストール完了後、ログインをしてvirt-ioのmsiをインストール

PrismからManage Guest Toolsもインストール

CDにマウントして、セットアップを実行。途中、エラーがでるけど無視していい。インストール後再起動を促されるので再起動

7.Nutanix CE仮想マシンのシャットダウンと起動

シャットダウン

ゲストVMを全て停止させる。

Nutanix CE仮想マシンにSSHでログイン (root nutanix/4u)

CVMへSSHでログイン (nutanix nutanix/4u)

ssh -l nutanix 192.168.10.122

cluster stop

sudo shutdown -h now

ー>CVMがシャットダウン

shutdown -h now

ー>Nutanix CE仮想マシンがシャットダウン

ー>これでESXの電源を落とせる。

起動

起動をしたらNutanix CE仮想マシンにSSHでログイン

ssh -l root 192.168.10.121

CVMが起動するまで数分まつ

virsh list

CVNにnutanixユーザ でログイン

ssh -l nutanix 192.168.10.122

cluster status

cluster start